Deep Networks with Stochastic Depth

1. どんなもの?

Residual Blockを確率的にドロップさせることで学習時間の向上や勾配消失を防ぐStochastic Depthを提案.

2. 先行研究と比べてどこがすごいの?

層のとても深いResNetといったモデルはBackpropagation時の勾配消失や,各パラメータが有効に学習しない,学習時間の増大などが問題点として上げられている.

本研究ではResNetを対象とした,層の深いネットワークを見かけ上浅いネットワークのように学習を行い,テスト時に元のDeepなネットワークとなるよう振る舞う”Stochastic Depth”を提案している.

3. 技術や手法の”キモ”はどこにある?

- Stochastic Depth

- Residual Blockを確率的にドロップさせる.

- 学習時間の短縮.

- モデルのアンサンブルのような働きがある.

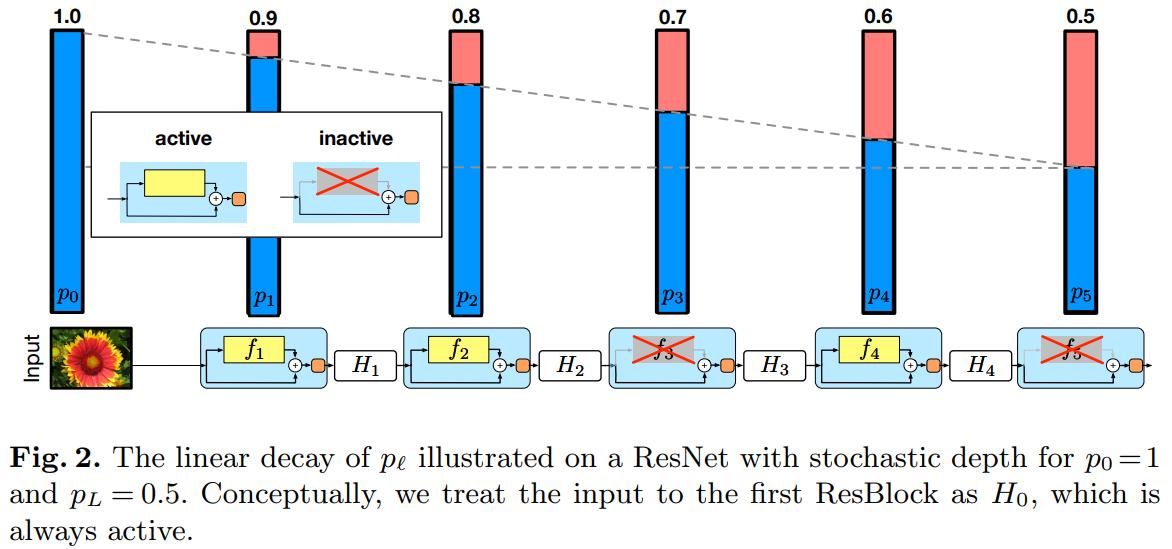

- survival probabilitiesを利用し,より深いResidual Blockをより多くドロップさせるようにする.

- 入力に近い,浅いブロックは1(Dropしない),深いブロックは0.5(50%の確率でDrop)するようにし,中間のブロックはこれらの値を考慮した線形値をドロップ確率としている.

- Dropoutはネットワークの幅を狭くするものであり,Stochastic Depthはネットワークの深さを浅くするものである.

- テスト時にはブロックをDropしないようにすることで表現能力の高い深いモデルを利用するようにする.

- Residual Blockを確率的にドロップさせる.

4. どうやって有効だと検証した?

CIFAR-10/100.SVHN,ImageNetの各データセットを使用し,ResNet-50と提案手法であるStochastic Depthを導入したResNet-50で比較を行っている.

Stochastic Depthを導入したResNetの学習時間は通常のResNetと比べるとおよそ25%ほど短縮されており,また通常のResNetより精度を出している.

5. 議論はあるか?

- survival probabilitiesについて

- 実験結果からsurvival probabilitiesは0.5が良い結果が出ている.

6. 次に読むべき論文はあるか?

ResNetについて