Max-Pooling Dropout for Regularization of Convolutional Neural Networks

1. どんなもの?

Max-pooling層の前にDropoutする「Max-Pooling Dropout」を提案し,学習時に活性化後の特徴量を多項分布に従ってサンプリングしていることと同等であることを示した.

2. 先行研究と比べてどこがすごいの?

Dropoutは最近Deep Learningに導入された正則化技術であり,通常全結合層に対して適用される.先行研究ではStochastic poolingやMaxout Networkといった,Dropoutにインスパイアされた正則化技術が提案されている.

本研究では通常全結合層の直前で用いるDropoutを,Max-pooling層の前で適用することで,学習時に活性化後の特徴量を多項分布に従ってサンプリングしていることと同値であることを示している.

またテスト時にProbabilistic Weighted Poolingを用いることで,トレーニングしたDropoutネットワークを平均化するより正確な近似を得ることができる.

3. 技術や手法の”キモ”はどこにある?

- Max-Pooling Dropout

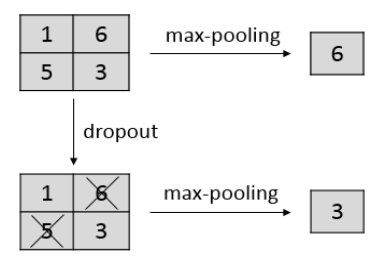

- 学習時にMax-Poolingする前にDropoutさせる

- 活性化後の特徴量を多項分布に従ってサンプリングしていることと同値

- Probabilistic Weighted Pooling

- 学習時にMax-Pooling Dropoutを適用したネットワークに対し,より正確なネットワークの平均を近似できる

4. どうやって有効だと検証した?

MNIST,CIFAR-10およびCIFAR-100データセットについて評価を行っている.

- Probabilistic Weighted PoolingとMax-Poolingをそれぞれ適用したモデルの比較実験

- dropout率が高い場合に提案手法のProbabilistic Weighted Poolingが優れたパフォーマンスを出している.

- Max-Pooling DropoutとStochastic Poolingをそれぞれ適用したモデルの比較実験

- dropout率0.5付近においてMax-Pooling DropoutがStochastic Poolingを超える結果を出している.

5. 議論はあるか?

6. 次に読むべき論文はあるか?

Stocastic Poolingについて

Maxout Networkについて