Random Erasing Data Augmentation

1. どんなもの?

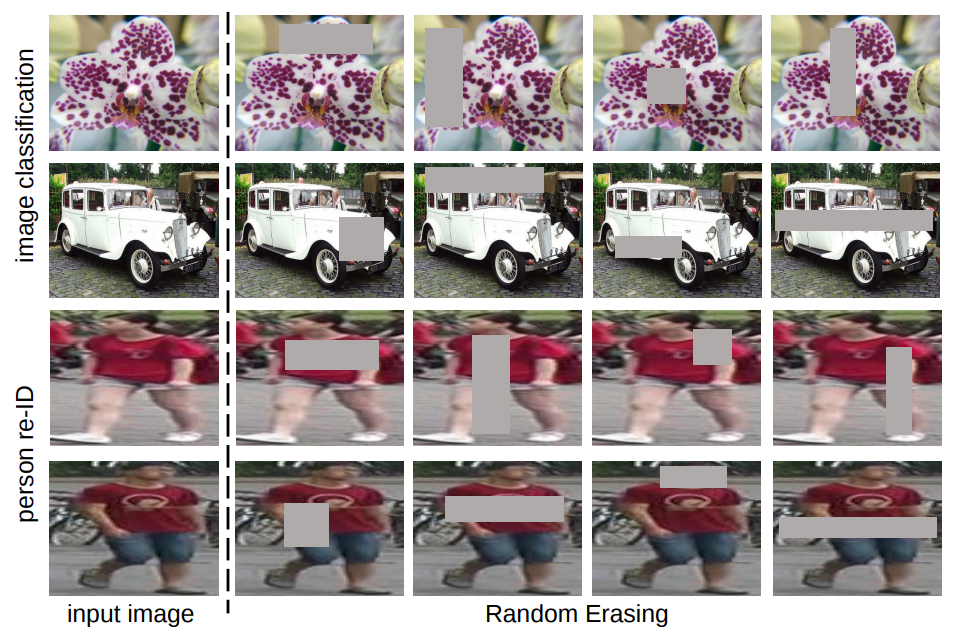

入力画像に対してランダムに矩形領域をノイズでマスクするRandom Erasingを提案し,モデルの識別精度を向上させる.

2. 先行研究と比べてどこがすごいの?

画像認識分野で素晴らしい結果を残しているConvolutional Neural Network(CNN)は多数の複雑なパラメータが存在しているため, トレーニングデータに対しては良い精度を表し,テストデータに対しては精度が悪くなってしまう「過学習」が問題になっている.

こうした問題に対して先行研究では以下のようなData augmentationや正則化を用いて過学習を抑制するよう提案を行っている.

- Translation

- Rotation

- Random flipping

- Random cropping

- Adding noises

- Dropout

- DropConnect

- Adaptive dropout

- Stochastic Pooling

- DisturbLabel

- PatchShuffle

本研究では以下のような利点があるRandom Erasingを提案している.

- パラメータの学習や省メモリで動く軽量な手法である.既存の学習の枠組みを変えることなく,さまざまなCNNモデルに適用することができる.

- 既存のData augmentationや正則化手法とRandom Erasingを組み合わせることにより,認識性能が更に向上する.

- 画像の一部分が隠されているようなサンプルに対するCNNのロバスト性を向上させる.ランダムに選んだテストデータに対して一部分を隠して推論させた場合においても高い性能を発揮する.

3. 技術や手法の”キモ”はどこにある?

- Random Erasing

- 入力画像に対してランダムに矩形領域をノイズでマスクする.

-

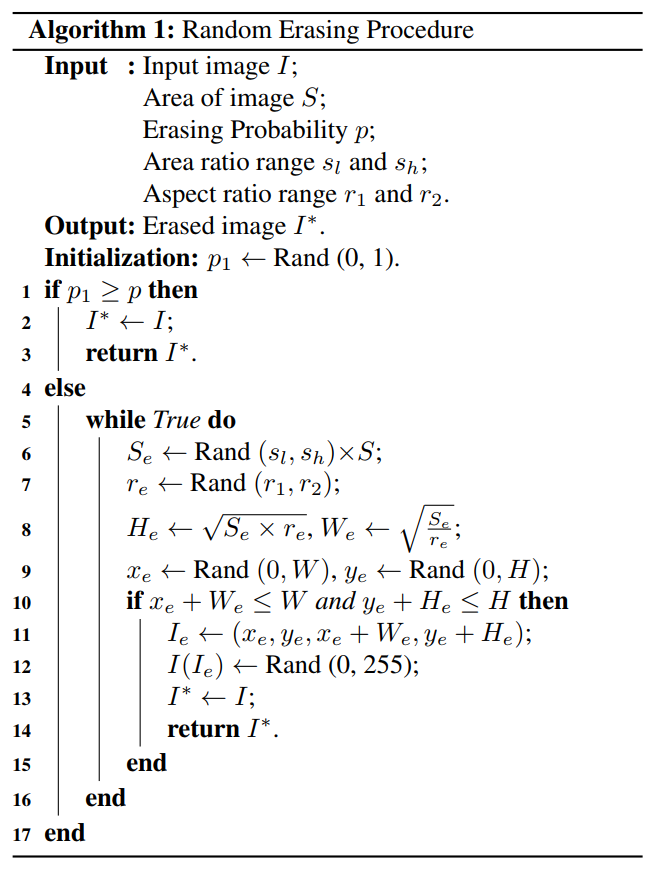

ハイパーパラメータ

パラメータ 説明 Erasing probability Random Erasingを使用する確率 Area ratio range , マスクする領域の最小/最大比率 (画像全体に対する面積比) Aspect ratio range , マスク領域のアスペクト比の最小/最大値 -

アルゴリズムは以下のようになっている.

-

- 入力画像に対してランダムに矩形領域をノイズでマスクする.

4. どうやって有効だと検証した?

画像分類タスクに対してはCIFAR-10/100,物体識別タスクに対してはPASCAL VOC 2007,人物の認識タスクに対してはMarket-1501,DukeMTMC-reID,CHHK03をそれぞれ利用している.

AlexNetやVGG19,ResNet,Wide ResNet,ResNeXt,FRCN,ASDNなど,さまざまなSoTAモデルに対してRandom Erasingを適用した結果を比較している.

5. 議論はあるか?

- Random ErasingはDropoutを画像レベルで適用しているもの似ている.

- Dropoutと異なる点

- 連続した矩形領域に対して適用している.

- ノイズや障害物に対してモデルをよりロバストにすることを重点に置いている.

- Dropoutと異なる点

6. 次に読むべき論文はあるか?

Dropoutについて

DropConnectについて

Adaptive dropoutについて

Stochastic Poolingについて

DisturbLabelについて

PatchShuffleについて